IBM เปิดตัว “Granite 4.0 Nano” โมเดลจิ๋วแต่แจ๋ว รันบนโน้ตบุ๊กได้ เปิดให้ใช้ฟรี

ในยุคที่วงการ AI มุ่งแข่งขันกันสร้างโมเดลภาษาขนาดใหญ่ (LLM) ที่มีพารามิเตอร์หลายแสนล้านตัว IBM กลับเลือกเดินสวนกระแส ด้วยการเปิดตัวโมเดล AI ในตระกูล “Granite 4.0 Nano” ซึ่งเป็นโมเดลแบบโอเพนซอร์สที่มีขนาดเล็กมาก แต่เปี่ยมด้วยประสิทธิภาพ สามารถทำงานแบบ Local บนอุปกรณ์ทั่วไปได้โดยไม่ต้องพึ่งพาทรัพยากรจากคลาวด์

ความเคลื่อนไหวครั้งนี้ถือเป็นการเปลี่ยนแนวคิดสำคัญ ที่เน้น “ประสิทธิภาพและความเข้าถึงได้” มากกว่า “ขนาดและความซับซ้อน” เปิดโอกาสให้นักพัฒนาและองค์กรสามารถนำ AI ไปประยุกต์ใช้ในแอปพลิเคชันต่างๆ ได้อย่างกว้างขวางและประหยัดยิ่งขึ้น

จิ๋วแต่ทรงพลัง

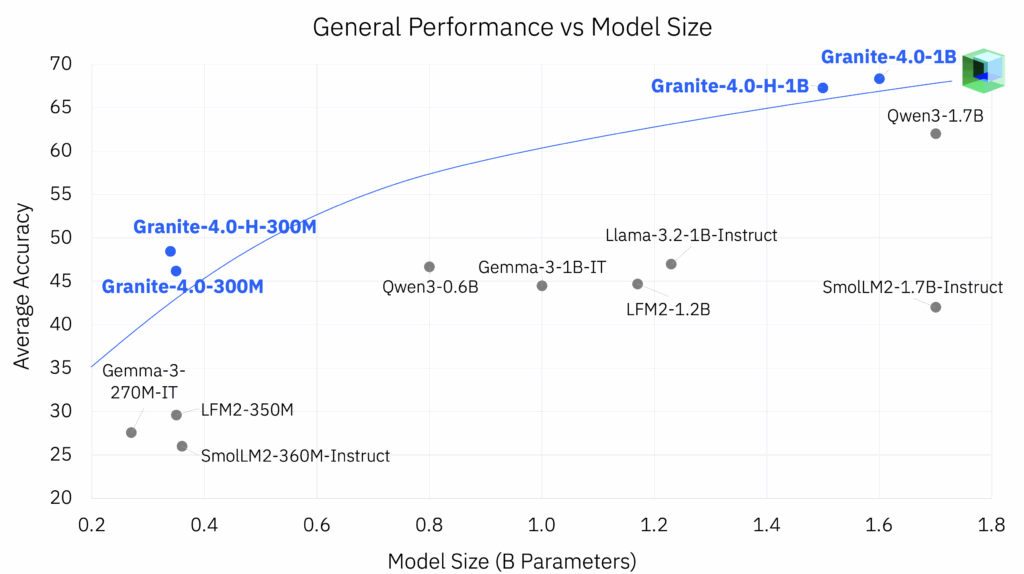

IBM ได้เปิดตัว Granite 4.0 Nano พร้อมกัน 4 รุ่น โดยมีขนาดพารามิเตอร์ตั้งแต่ 350 ล้าน ถึง 1.5 พันล้านพารามิเตอร์ ซึ่งถือว่าเล็กมากเมื่อเทียบกับโมเดลจากคู่แข่งรายใหญ่อย่าง OpenAI, Anthropic หรือ Google

จุดเด่นที่สำคัญคือการออกแบบมาให้ใช้ทรัพยากรน้อยมาก

- Granite-4.0-H-350M รุ่น 350 ล้านพารามิเตอร์: สามารถทำงานได้อย่างราบรื่นบน CPU ของแล็ปท็อปทั่วไปที่มี RAM เพียง 8-16GB

- Granite-4.0-H-1B รุ่น 1.5 พันล้านพารามิเตอร์: ต้องการการ์ดจอ (GPU) ที่มี VRAM อย่างน้อย 4-8GB หรือใช้ RAM ของเครื่องในการประมวลผลผ่าน CPU ก็ได้

ด้วยขนาดที่เล็กและประหยัดทรัพยากรนี้ ทำให้โมเดล Granite 4.0 Nano เหมาะอย่างยิ่งสำหรับนักพัฒนาที่ต้องการสร้างแอปพลิเคชันสำหรับอุปกรณ์ปลายทาง (Edge computing) หรือทำงานบนฮาร์ดแวร์ระดับผู้บริโภคทั่วไป ที่น่าทึ่งไปกว่านั้นคือ โมเดลขนาดเล็กสุดสามารถทำงานได้แบบ 100% ภายในเว็บเบราว์เซอร์ โดยใช้เทคโนโลยี WebGPU ในการเร่งความเร็ว

สถาปัตยกรรมแบบไฮบริด และเปิดให้ใช้ฟรี

เบื้องหลังประสิทธิภาพที่น่าทึ่งนี้คือสถาปัตยกรรมแบบไฮบริดที่ผสมผสานระหว่าง “Mamba” และ “Transformer” ซึ่งช่วยลดการใช้หน่วยความจำลงได้อย่างมากถึง 70% เมื่อเทียบกับโมเดลขนาดใกล้เคียงกัน โดยที่ประสิทธิภาพไม่ได้ลดลง

IBM ได้เปิดให้ใช้งานโมเดล Granite 4.0 Nano ทั้งหมดภายใต้ลิขสิทธิ์ Apache 2.0 ซึ่งอนุญาตให้นักวิจัย, องค์กร, และนักพัฒนาอิสระสามารถนำไปใช้งานได้ฟรี แม้กระทั่งในเชิงพาณิชย์ นอกจากนี้ยังเป็นโมเดลโอเพนซอร์สรุ่นแรกของโลกที่ได้รับการรับรองมาตรฐาน ISO 42001 ด้านการจัดการ AI อย่างมีความรับผิดชอบ

การมาถึงของ Granite 4.0 Nano จึงเป็นการเปิดศักราชใหม่ของ AI ที่เน้นการทำงานแบบ Local ซึ่งไม่เพียงแต่ช่วยลดต้นทุนด้านโครงสร้างพื้นฐาน แต่ยังเพิ่มความเป็นส่วนตัวและความปลอดภัยให้กับผู้ใช้งาน เนื่องจากข้อมูลไม่ต้องถูกส่งไปประมวลผลบนคลาวด์อีกต่อไป